Der Einsatz von Künstlicher Intelligenz in der Medizin bietet Chancen für präzisere Diagnosen und die Entlastung von Routinetätigkeiten. Doch welches Verständnis der Technologie benötigen Medizinerinnen und Mediziner, um das „richtige“ Maß an Vertrauen in solche Systeme zu entwickeln? Gibt es ethisch relevante Rückwirkungen durch den Einsatz von KI in der Beziehung zwischen Arzt und Patienten? Solchen Fragestellungen geht ein Projekt unter Leitung der Technischen Hochschule Ingolstadt (THI) und der Katholischen Universität Eichstätt-Ingolstadt (KU) nach. Kooperationspartner sind Prof. Dr. Matthias Uhl (Professor für Gesellschaftliche Implikationen und ethische Aspekte der KI) und Prof. Dr.-Ing. Marc Aubreville (Professor für Bildverstehen und medizinische Anwendungen der Künstlichen Intelligenz) von der THI sowie Prof. Dr. Alexis Fritz (Inhaber des Lehrstuhls für Moraltheologie) von der KU. Gefördert wird das Projekt mit dem Titel „Responsibility Gaps in Human-Machine Interactions: The Ambivalence of Trust in AI“ vom Bayerischen Forschungsinstitut für Digitale Transformation (bidt).

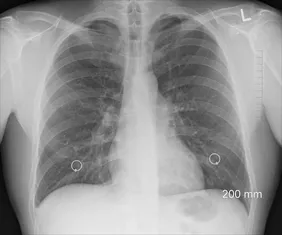

Monotone Tätigkeiten sind für Menschen ermüdend und zeitaufwändig. Die gleichförmige Auswertung von Dutzenden Mammographien durch erfahrene Medizinerinnen und Mediziner kann zum Beispiel den Nebeneffekt haben, dass kleine, aber für die Diagnose wichtige, Details übersehen werden. Der Einsatz von KI kann hier potenziell entlasten und menschliche Entscheidungsträger unterstützen. „Grundvoraussetzung ist, dass die menschlichen Experten dem KI-System vertrauen können müssen. Allerdings kann dies auch dazu führen, dass der Arzt oder die Ärztin die Entscheidung der KI nicht mehr kritisch überprüft“, sagt Prof. Dr. Marc Aubreville. Denn auch solche Systeme, die im medizinischen Bereich bereits zum Einsatz kommen, sind nicht unfehlbar. Deshalb sind in den Abläufen nach wie vor Menschen als letzte Entscheidungsinstanz vorgesehen.

Doch genügt dies, um eine seriöse Verantwortlichkeit in der Interaktion von Mensch und Maschine festzulegen? „Der einfache Ansatz, einen Menschen in die Abläufe zu integrieren, um fehlgeleitete Entscheidungen zu korrigieren, ist zu naiv“, erklärt Prof. Dr. Alexis Fritz. Denn so wie sich Menschen weniger verantwortlich fühlten, wenn sie gemeinsame Entscheidungen mit anderen Menschen treffen, zeigten Studien, dass dies auch gelte, wenn menschliche Entscheider von einem Empfehlungssystem beraten worden seien. Prof. Dr. Matthias Uhl fasst die Ergebnisse seiner eigenen empirischen Studien wie folgt zusammen. „In verschiedenen moralisch relevanten Entscheidungskontexten sehen wir, dass Menschen sogar dann noch den Empfehlungen einer KI folgen, wenn wir ihnen gute Gründe dafür geben an den Empfehlungen des Systems zu zweifeln, beispielsweise an der Qualität der Trainingsdaten.“

„Aus Perspektive der Ethik ist es zu eng gefasst, KI-Systeme nur rein technisch zu optimieren. Wir wollen daher zum Beispiel vergleichen, wie sich verhält, wenn nicht die KI die erste Empfehlung ausspricht, sondern eine Ärztin oder ein Arzt zuerst eine Diagnose stellt, die dann erst im zweiten Schritt von der KI validiert wird“, schildert Fritz. Er wird die normativen Voraussetzungen dafür erforschen, dass sich Entscheider ihrer Handlungsfähigkeit bewusst bleiben und weniger Verantwortung auf eine KI abwälzen. Zu diesem Zweck werden bereits bestehende Studien zu den ethischen Herausforderungen der Interaktion zwischen Medizinern und KI-basierten Systemen recherchiert und analysiert. Die verschiedenen Konzepte von Verantwortung und Rechenschaftspflicht werden dann in der medizinischen Praxis durch Workshops und qualitative Interviews mit Medizinern und Ingenieuren evaluiert. Dabei wird unter anderem auch die Beziehung zwischen Arzt und Patienten eine Rolle spielen: Haben die Ärzte zum Beispiel das Gefühl, dass ihre Autorität vor den Patienten in Frage gestellt wird, wenn sie ein Empfehlungssystem konsultieren?

Generell wollen die Projektbeteiligten Erkenntnisse für die Entwicklung von nutzerbewussten KI-Lösungen liefern. „Heute werden viele Lösungen ohne Rücksicht auf die nachfolgenden Entscheidungsprozesse entworfen. Wir werden daher auf der Grundlage unserer Erkenntnisse bewerten, wie algorithmische Ergebnisse und Unsicherheiten dem zuständigen Experten am besten präsentiert werden können. Ziel dabei ist es, das Vertrauen in die Ratschläge von Empfehlungssystemen richtig zu gewichten, insbesondere in Situationen außerhalb der Norm, in denen der Algorithmus möglicherweise nicht den besten Hinweis liefert“, so Fritz.