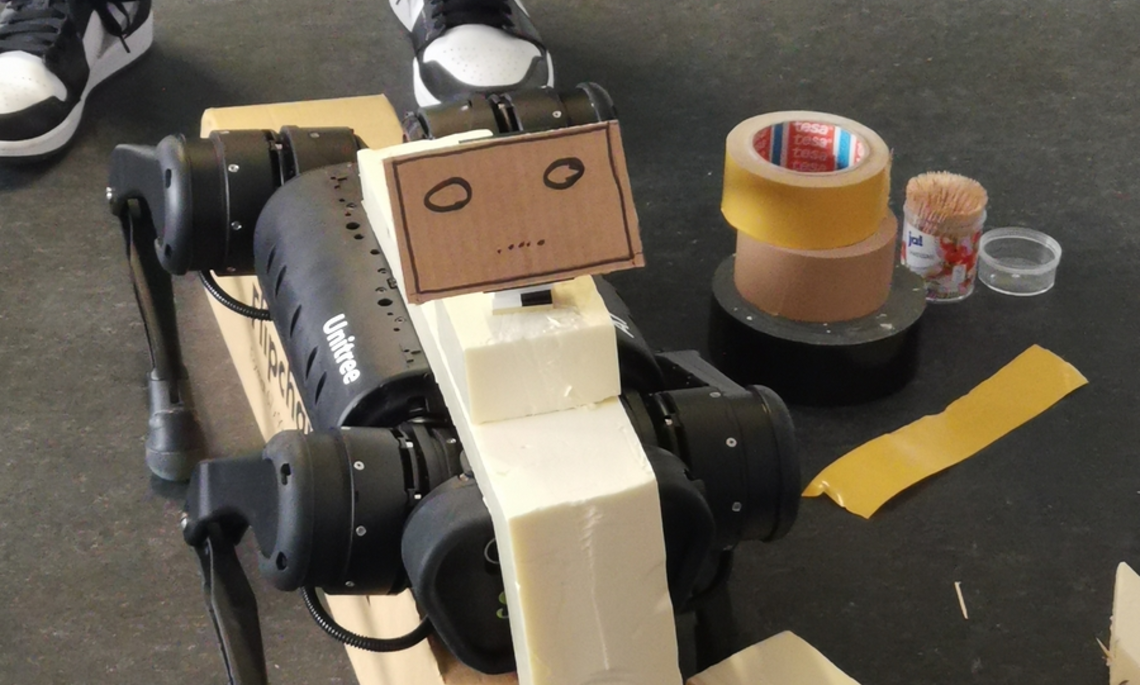

Im interdisziplinären Projekt „Empathy with aN AutonoMOUs Robot“ (ENAMOUR) im Sommersemester 2022 ging es um die Entwicklung eines empathischen Roboters. Christian Anghelide von der AININ gGmbH formulierte es bei der Abschlusspräsentation treffend: „Wir (AININ) brachten einen Roboter, und bekommen einen (Roboter)Hund zurück“.

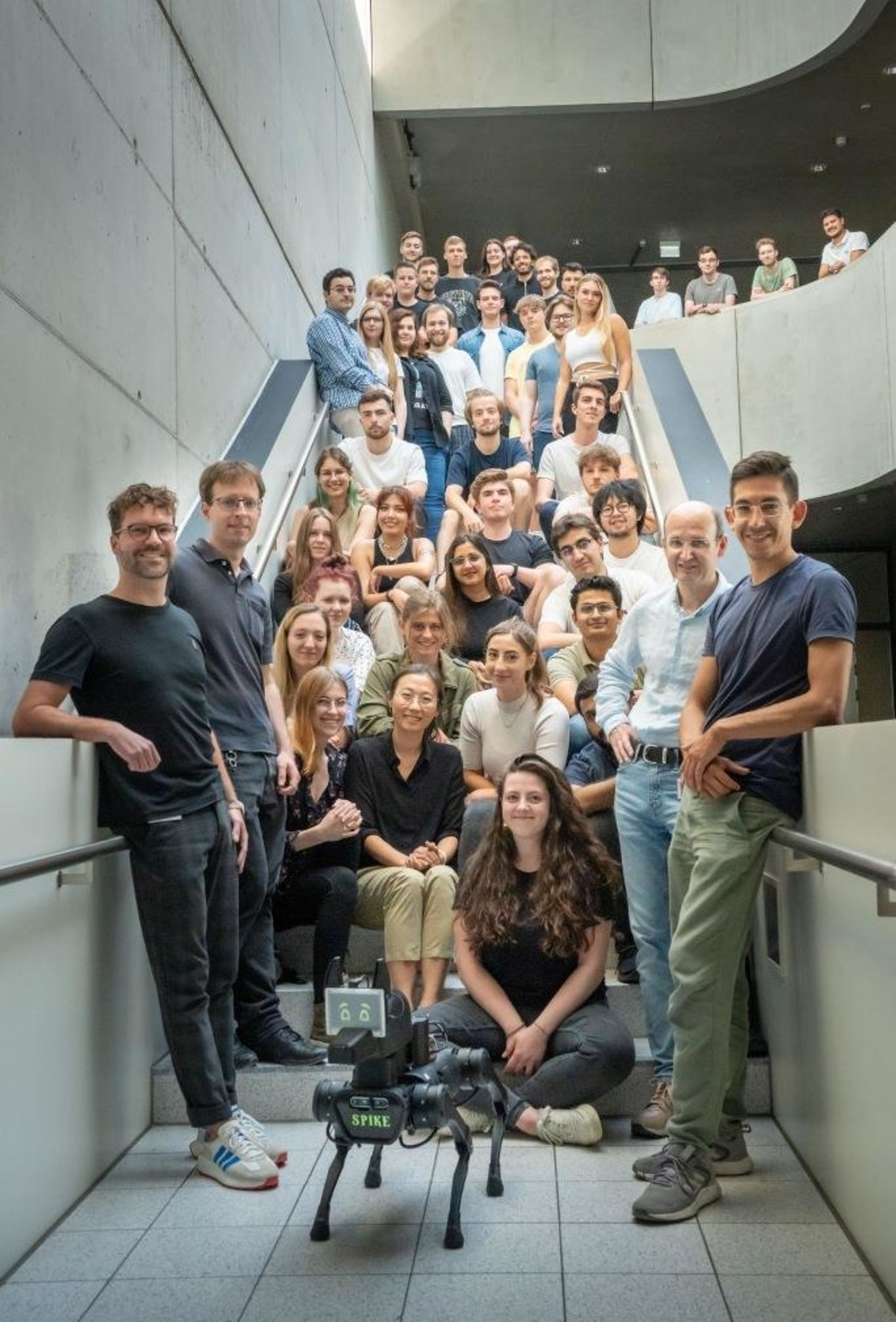

Insgesamt waren 35 Studierende aus 4 verschiedenen Studiengängen (Künstliche Intelligenz, UX-Design, Informatik und Maschinenbau) an der Weiterentwicklung des Roboterhundes beteiligt. Um die Betreuung der 4 Studiengruppen kümmerten sich Prof. Dr. Gerhard Elsbacher, Prof. Dr. Stefan Kugele, Prof. Dr. Munir Georges und Mariano Frohnmaier.

Ziel

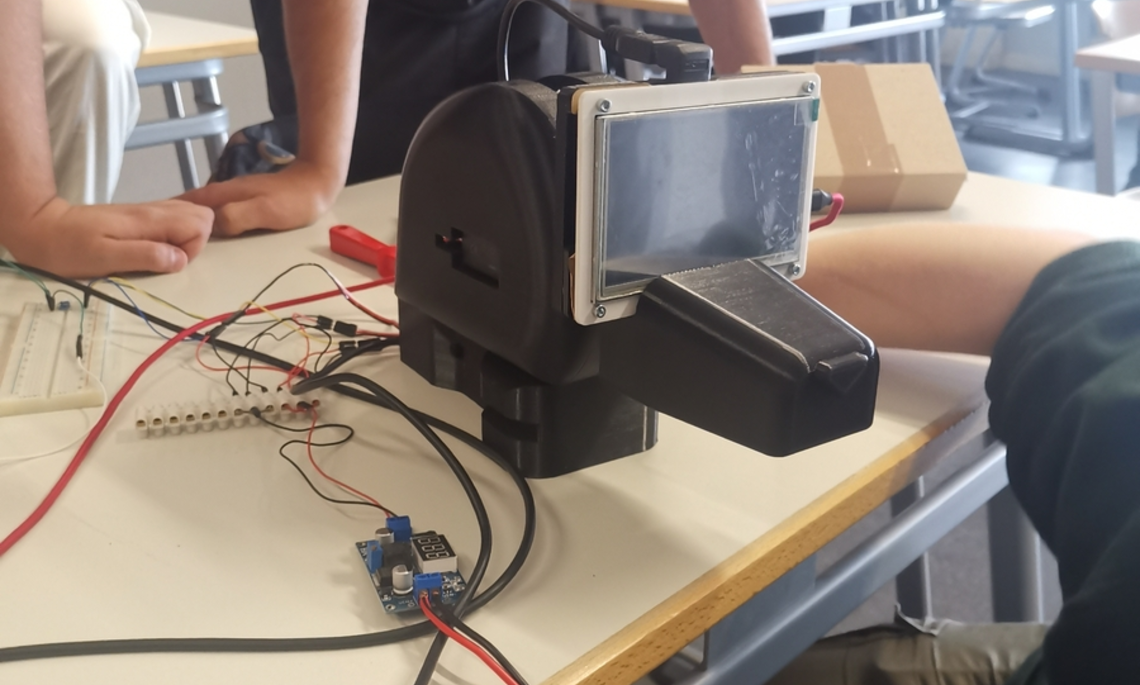

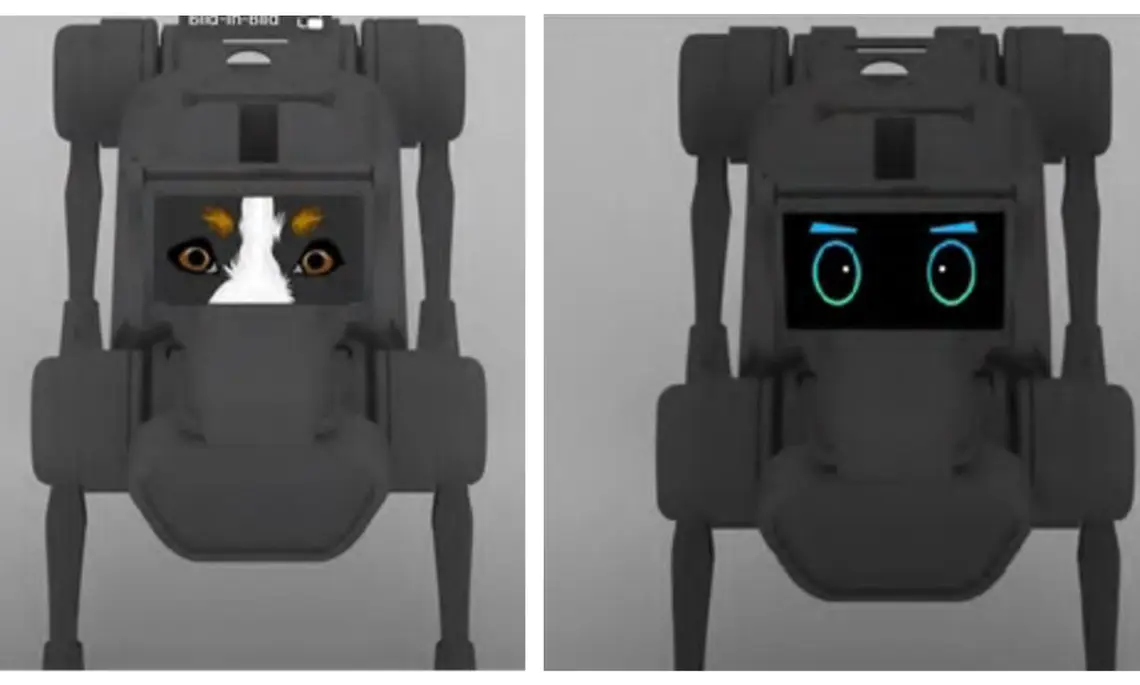

Der Roboterhund "Spike" sollte in der Lage sein, Emotionen aus geäußerten Sprachkommandos von Frauchen bzw. Herrchen richtig zu interpretieren und daraufhin emotional zu antworten, z. B. durch geeignete Körpersprache, Mimik und Geräusche.